Tehnologijom može da se izvede da izgleda kao da je neko nešto rekao ili uradio. Da li je ovo novi talas ratovanja (dez)informacijama?

U maju 2018. godine, na internetu se pojavio video sa Donaldom Trampom kako daje savjet Belgijancima po pitanju klimatskih promjena. „Kao što znate, usudio sam se da se povučem iz Pariškog klimatskog sporazuma“, rekao je gledajući pravo u kameru, „što bi i vi isto trebali da uradite“.

Ovaj video napravila je belgijska politička partija Socijalistička partija Drugačije (njem. Socialistische Partij Anders), skraćeno sp.a, i postavila ga na njihov Tviter i Fejsbuk nalog. Video je izazvao hiljade komentara, od kojih su mnogi odisali bijesom jer se američki predsjednik usudio da komentariše na temu belgijske politike prema klimatskim promjenama.

Ali ovaj bijes je bio usmjeren u pogrešnom pravcu. Govor, kako se kasnije ispostavilo, bio je ništa drugo do krivotvorina napravljena upotrebom visoke tehnologije.

Iz sp.a su tvrdili da su tražili od jednog produkcijskog studija da koristeći mašinsko učenje naprave ono što je poznato kao „dipfejk“ video – kompjuterski napravljena kopija osobe, u ovom slučaju kopija Trampa, koja govori ili radi stvari koje ta osoba nikada ne bi izgovorila ili uradila.

Ono što je bila namjera sp.a jeste da iskoriste ovaj lažni video da bi privukli pažnju ljudi, a zatim je preusmjere na onlajn peticiju kojom se poziva belgijska vlada da preduzme hitnije radnje po pitanju klimatskih promjena. Tvorci videa su kasnije rekli da su mislili da je loš kvalitet ovog lažnjaka dovoljan da ukaže pratiocima da nije vjerodostojan. „Jasno se vidi dok se usne pomjeraju da nije u pitanju originalni Trampov govor“, rekla je portparolka stranke sp.a za Politico.

Kako je postalo jasno da je njihova politička šala otišla u drugom smjeru, tim za društvene mreže iz ove partije krenuo je da smanjuje štetu. „Ćao Teo, ovo je zabavni video. Trump nije zapravo dao ovakve izjave.“ „Zdravo, Dirk, ovaj video je predviđen kao šala. Trump nije zaista ovo rekao.“

Tim za komunikacije iz ove partije je očigledno podcijenio moć svoje krivotvorine, ili je možda precijenio moć rasuđivanja svoje publike. Kako god da bilo, ova mala, ljevičarski okrenuta politička partija je, možda nesvjesno, dala veoma zabrinjavajuć primjer korišćenja manipulativnih video sadržaja na internetu u otvoreno političkom kontekstu.

Bio je to manji primjer kako ova tehnologija može biti iskorišćena da bi se ugrozio naš ionako ranjiv informacioni ekosistem – i možda dovela u pitanje mogućnost sigurne, podjeljene stvarnosti.

Mišljenja stručnjaka

Daniela Sitron, profesorica prava na Univerzitetu u Merilendu, je zajedno sa svojom koleginicom Bobi Česni počela da radi na izvještaju u kome ističu razmjere potencijalne opasnosti. Pored toga što su u svom radu razmotrile opasnost po privatnost i nacionalnu bezbjednost, oba akademika su veoma zabrinuta da bi nagli rast u pravljenju „dipfejk“ videa mogao strašno da poljulja povjerenje među frakcijama društva u i ovako polarizovanom političkom vremenu.

Štaviše, već su mogle da predvide kako „dipfejk“ zloupotrebljavaju „snadbjevači“ lažnih vijesti. Bilo ko ima pristup ovoj tehnologiji – od propagandista koje je država sankcionisala do trolova – bi mogao da izvrće informacije, manipuliše vjerovanjima i na taj način gurne ideološki suprostavljene onlajn zajednice još dublje u njihove subjektvne realnosti.

„Tržište ideja već pati zbog iščezavanja istine, dok naša umrežena informaciona sredina štetnim putem dolazi u kontakt sa našim kognitivnim predrasudama“, piše u izvještaju. „Dipfejkom će se ovaj problem još više pogoršati“.

Sitron i Česni nisu jedine koje se plaše ovoga. U aprilu 2018. godine, reditelj Džordan Piel i BuzzFeed su objavili „dipfejk“ video u kome Barak Obama naziva Trampa „potpunim i kompletnim idiotom“ da bi podigli svijest o tome kako bi sintetički mediji napravljeni uz pomoć vještačke inteligencije mogli biti iskorišćeni da se iskrivi i izmanipuliše realnost.

U septembru 2018. godine, tri člana Kongresa su poslala pismo direktoru nacionalne objavještajne službe, upozoravajući o tome kako bi „dipfejk“ mogle iskorisiti „kampanje dezinformisanja tokom izbora“.

Iako bi se ovakve uznemirujuće teorije mogle lako prizvati, Tim Hvang, direktor Inicijative za etiku i upravljanje vještačkom inteligencijom na Harvardu-MIT, se ne bi baš kladio da će „dipfejk“ videa imati veliki uticaj na izbore u bliskoj budućnosti. Već nekoliko godina Hvang proučava širenje dezinformacija putem internet mreže i, uz izuzetak ovog manje značajnog incidenta u Belgiji, tek treba da vidi „u prirodi“ neki primjer zaista pogubnog slučaja izazvanog „dipfejk“ videom.

Hvang vjeruje da je to razlog jednim dijelom zbog toga što korišćenje mašinskog učenja da bi se napravili uvjerljivi lažni videi ipak zahtjeva neki stepen stručnosti i mnogo podataka. „Ako ste propagandista, želite što dalje da prenesete svoj rad, uz što manje truda“, rekao je. „Danas, i neki grubo napravljen Fotošop može da bude jednako efektan kao i nešto što je napravljeno korišćenjem mašinskog učenja“.

Istovremeno, Hvang priznaje da budući da u godinama koje dolaze „dipfejk“ sve više postaje dio realnosti i lakše ga je napraviti, mogla bi biti uvod u doba krivotvorenja koje je po kvalitetu drugačije od onoga koje smo vidjeli ranije. U prošlosti, na primjer, ako ste željeli da napravite video predsjednika kako govori nešto što nije rekao, bio vam je potreban tim stručnjaka. Dok danas, uz mašinsko učenje ne samo da ćete automatizovati ovaj proces, već ćete biti u mogućnosti da napravite i bolju krivotvorinu.

Povežite ovo sa činjenicom da će se ova tehnologija proširiti internetom i odjednom imate, kako je Hvang rekao, „savršen talas misinfromacija“.

Uspon tehnologije

Bilo kako bilo, istraživanje u oblasti sintetičkih medija proizvedenih mašinskim učenjem napreduje.

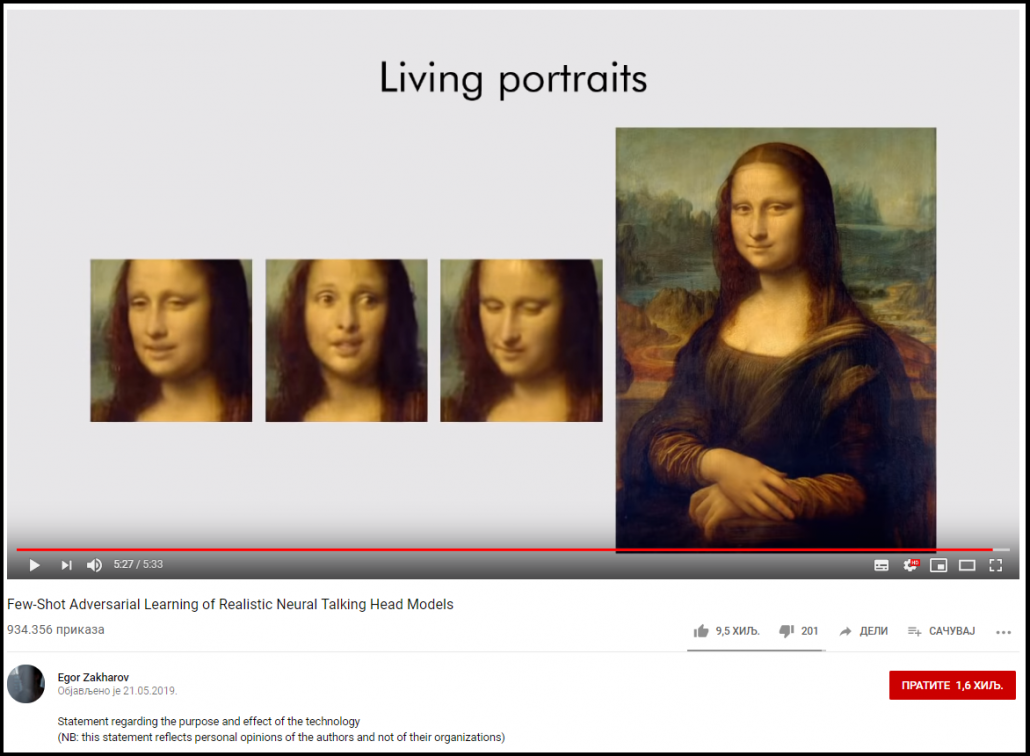

Da bi se napravio uvjerljiv „dipfejk“ video često vam je potreban neuralni model koji se trenira uz pomoć puno referentnog materijala. Uopšte, što više slika, videa ili zvukova vaša baza podataka sadrži, to će vaš rezultati biti neopisivo vjerodostojniji. Ali ovoga maja, istraživači u Samsungovom centru za vještačku inteligenciju u Moskvi razvili su metodu za treniranje modela tako da se pokreće uz veoma ograničenu bazu podataka: samo jedna slika je dovoljna i rezultati su iznenađujuće dobri.

Istraživači su uspjeli da naprave „fotorealistične modele glava koje se pomjeraju“ koristeći konvolucione neuronske mreže: trenirali su algoritam na velikoj bazi podataka sa videima glava koje se pomjeraju i to sa različitom fizionomijom. U ovom slučaju, koristili su javno dostupnu bazu podataka VexCeleb koja sadrži više od 7.000 slika poznatih ličnosti sa Jutjuba.

Uz pomoć ovoga trenirali su program da prepozna ono što oni nazivaju „prepoznatljivim“ crtama lica: oči, oblici usana, dužina i oblik nosnog mosta.

Ovo, na neki način, predstavlja skok u poređenju sa onim što se čak „dipfejkom“ i drugim algoritmima koji koriste generativne kontradiktorne mreže može postići. Umjesto da uče algoritam kako da nalijepi jedno lice na drugo koristeći lepezu izraza lica jedne osobe, oni koriste crte lica koje su uobičajene kod svih ljudi da bi na kraju napravili novo lice.

Kao što je ovaj tim i dokazao, njihov model može da se primjeni čak i na Mona Lizi, i drugim portretima kod kojih postoji samo jedan primjerak. U ovom videu, poznati portreti Alberta Anštajna, Fjoroda Dostojevskog i Merilin Monro oživljavaju kao da su live slike na iPhone-ovoj kameri. Ako kao što je to slučaj sa mnogim „dipfejk“ videima, u ovoj fazi je veoma lako vidjeti „šavove“. Većina lica je okružena vizuelnim artefaktima.

Nove metode za otkrivanje

Kako se opasnost od „dipfejk“ videa povećava, tako se povećavaju i napori za stvaranjem novih metoda za otkrivanje istih. U junu 2018. godine, istraživači sa Univerziteta u Olbaniju (SUNY) su objavili rad u kome ističu kako lažni videi mogu da se otkriju tako što se kod sintetičkog subjekta vidi da ne trepće. Fejsbuk je takođe odlučan da razvije modele mašinskog učenja za otkrivanje „dipfejk“ videa.

Međutim, Hani Farid, profesor kompjuterskih nauka na Univerzitetu u Kaliforniji, u Berkliju, je nepovjerljiv. On vjeruje da oslanjanje samo na forenzičko otkrivanje da bi se borili protiv „dipfejk“ videa postaje sve manje izvodljivo, naročito zbog stope kojom tehnike mašinskog učenja mogu da ga zaobiđu. „Nekada smo imali razmak od nekoliko godina prije nego bi falsifikatori našli način da zaobiđu napravljene tehnike za otkrivanje. Sada je taj razmaka dva do tri mjeseca.“

Ovo, on objašnjava, se dešava zbog fleksibilnosti u mašinskom učenju. „Sve što programeri treba da urade jeste da ažuriraju algoritam tako da potraži, recimo, promjene u boji lica koje odgovaraju otkucaju srca, i onda iznenada, lažnjak integriše ovaj nekada neprimjetni znak.“

Iako se Farid nalazi u ovoj tehnološkoj igri mačke i miša sa tvorcima „dipfejk“ videa, svjestan je da se rješenje ne nalazi samo u novoj tehnologiji. „Problem nije samo u tome što „dipfejk“ tehnologija postaje bolja“, kaže. „Riječ je o tome da su društveni procesi, putem kojih svi zajedno dolazimo do saznanja i smatramo da su tačna ili netačna, u opasnost

Ravnodušnost prema stvarnosti

I zaista, kao što je to i lažni video Trampa koji se širio društvenim mrežama u Belgiji pokazao – video za koji se kasnije ispostavilo da nije napravljen uz pomoć tehnologije mašinskog učenja, kao što su to iz sp.a partije tvrdili, već korišćenjem softvera za uređivanje pod imenom After Effect – „dipfejk“ videa ne treba da budu neprimjetna ili čak uvjerljiva da bi im se povjerovalo i da bi načinili štetu. Moguće je da najveća prijetnja koju predstavljaju „dipfejk“ video snimci ne leži u samom lažnom sadržaju, već u pukoj mogućnosti njihovog postojanja.

Ovo je fenomen koji je akademik Aviv Ovadja nazvao „ravnodušnost prema stvarnosti“, gdje stalni kontakt sa dezinformacijama tjera ljude da prestanu da vjeruju onome što vide i čuju. Drugim riječima, najveća prijetnja nije u tome da će ljudi da budu ombanuti, već da će početi sve da posmatraju kao obmanu.

Nedavne ankete pokazuju da povjerenje u glavne institucije i medije opada. Širenje „dipfejk“ video snimaka, kaže Ovadja, će vjerovatno pogoršati ovaj trend.

Prema Danieli Sitron, već možemo da vidimo društvene posljedice ovog epistemičkog iščezavanja. „U krajnjem, „dipfejk“ videa samo povećavaju ono što ja zovem „dividenda lažljivca“, rekla je. „Kada ništa nije istina, tada će i neiskrena osoba prosperirati tako što će za ono što je istina da govori da je laž“.